2014年12月31日 星期三

[閒聊] 2015願望清單

2014年結束了,這年發生很多事情和變化。最大的改變在於心態上,當真正發現自己的渺小和不足後,對於很多事情都變得更加饑渴。開始學寫程式,學習演算法,對於政治和社會也有更多的參與。雖然自覺仍然不學無術,但是回頭看還是了累積不少東西。明年仍然會順著今年的方向,更加踏實的前進。

2014年12月30日 星期二

[Python] Google 經緯度查詢Api

隨著圖資的開放和普及,GIS資料也越來越受到重視.要結合一般的資料和圖資資料之間一個關鍵就是地址和經緯度(這邊不討論不同座標標示系統的用法...)通常我們比較容易知道的是地址資料,經緯度就要透過握有圖資的單位才能查到(例如:

http://tgos.nat.gov.tw/tgos/web/tgos_home.aspx).但是政府查詢還要申請,使用上也有所限制,好險偉大的google大神也有開放API可以查詢(Orz),為了使用方便就寫了一個簡單的API跟Python接口:

2014年12月29日 星期一

[Python][教學] 網路爬蟲(crawler)實務(下)--爬蟲策略以及設定

在知道目標之後,接著就要決定如何達成。網路爬蟲的概念很簡單,就是進入網頁之後,將網站中的原始碼擷取下來,透過Xpath或是Html節點的方式來找到目標字串。根據上次[Python][教學] 網路爬蟲(crawler)實務(上)--網頁元件解析分析的內容,我們的爬網策略大致上會是:

2014年12月27日 星期六

[Python][教學] 網路爬蟲(crawler)實務(上)--網頁元件解析

今年部落格最受歡迎文章:[Python] 現學現賣之網路爬蟲(Crawler)--以抓本BLOG為例是我剛學python時寫的程式,內容其實也都是照著老師的課程講義來做,很多細節也是矇懞懂懂.至今過了半年,爬網的經驗也多了一點,比較有內容可以跟大家分享.爬網有很多種用途,對比起搜尋引擎的全頁抓取,更多時候是抓取特定網站的特定內容,這時候除了爬蟲程式本身之外,對於網站欄位的解析更為重要.

2014年12月24日 星期三

[Apache Spark][開發] Spark 1.2.0發佈囉

昨天Spark 1.2.0正式release囉!(https://spark.apache.org/news/spark-1-2-0-released.html)這次更新了不少東西.主要是增加了效能和穩定性,一些心得API,PYTHON的支援等等,以下將翻譯一些重要的部分:

2014年12月21日 星期日

[Scala][教學] 神奇的Currying

話先說在前頭,本篇文章跟NBA的Curry完全一點關係都沒有,標準圖文不符.最近在Coursera上按表操課上著scala的課程,每一堂十分鐘的課程真的從頭到尾要弄懂每個語法細節大概都要花上一個多小時,跟當初看著codecademy自學python順順走的經驗差超多Orz.所以做的分享也只能是很簡單的到處搜集資料的結果,離應用還差上超大一截.

2014年12月17日 星期三

[Python][教學] Scrapy(Web Crawler) to PostgreSQL(二)postgreSQL資料庫連接設定

上一篇[Python] Scrapy(Web Crawler) to PostgreSQL(一)簡介 & 爬蟲基本設定介紹了網路爬蟲的基本設定後,這篇就是要接著介紹如何設定postgreSQL.首先我們要先安裝PostgreSQL(

安裝好DB後,繼續回到Scrapy上.要連結並操作PostgreSQL,有幾個檔案需要設定,以下將一一介紹:

2014年12月13日 星期六

[Python][教學] Scrapy(Web Crawler) to PostgreSQL(一)簡介 & 網路爬蟲基本設定

Scrapy是python上很受歡迎的爬網框架,官方網站為:http://doc.scrapy.org/en/latest/index.html.介紹Scrapy的網站很多,官網自己就寫得很清楚,一些中文化的資料可參考像是http://www.addbook.cn/book/scrapy中文手册等資料.今天主要介紹的是爬網之後的動作.爬網並不是單純爬文而已,而是為了提供之後進一步的分析,所以資料都必須儲存下來,儲存的方式有很多種,可以單純是個file,再由分析軟體來處理資料,或是把資料放在資料庫中,做進一步的分析.

2014年12月9日 星期二

[Python]神級 Coder 絕不犯的錯誤:為炫耀編出超短碼(疑?)

最近有個文章很紅: 神級 Coder 絕不犯的錯誤:為炫耀編出超短碼在python界引起了一陣討論,主旨是在說不要為了炫耀自己實力寫出超級精簡,但是很難維護,別人很難懂的程式碼。這個觀念不是不對,但是引用了錯誤的例子而遭到"熱烈"的討論。

2014年12月4日 星期四

Step by Step 使用github參與專案流程(後記)- 媽~我被Merge啦!

病了兩天,早上看到這個令人振奮的好消息,貢獻給gcloud的code被merge啦~(撒花)雖然只是短短幾行code,但是能對網路社群有個小小的貢獻還是非常開心,記錄一下這個patch的前因後果.

2014年12月3日 星期三

[Apache Spark][基本架構] RDD特性(三)- RDD之間的依賴關係(Dependency)

延續[Spark][基本架構] RDD特性(二)- 轉換(Transformations)和行動(Actions)提到的,RDD在進入行動之前,都是在不同的RDD之間做轉換,RDD會記錄下這些轉換過程,自己這個RDD是從哪個RDD(又稱為parentRDD)轉換過來的,這層父與子的關係就稱為Dependency(依賴關係).本篇文章會進一步說明依賴關係的類別.

2014年12月2日 星期二

[Apache Spark][基本架構] RDD特性(二)- 轉換(Transformations)和行動(Actions)

其實Spark架構不大,但是真的一環扣著一環,拆開來講會有很多問題,但是當每個環節都搞懂後就覺得一切設計的又是非常合理(非常繞口的一段話).這幾篇基本架構的文章都是根據Spark的原始論文拆出來講的,試圖將Spark的基本精神跟各位分享.

2014年11月30日 星期日

不關心政治的懲罰,就是被糟糕的人統治-柏拉圖

得知選舉結果後,內心很激動.台灣真的能不靠抹黑和樁腳固票來取得人民的支持與認同(一方面也是對方太差啦).

這次選舉很不一樣,過去大家都說政治很黑暗,不要碰,自己也對這種鬧劇或只是權貴集團的遊戲沒什麼興趣,但這次身邊很多認識的人都投入了選戰之中,無論是幫忙的義工,或是本身就是參與者.第一次有哪麼多出身背景相似(就是沒什麼背景)的人,投入到政治之中,的確認政治離我們更近了一點,有機會看到那一點共同的未來.很高興大家的熱情與付出都有了結果,雖仍有不完滿,但也大大超出了我們自己原本的想像.

民主政治不需要神人,而是需要公民的共同參與,除了手上那張選票之外,平日的監督更是必要,只有親自參與政治,才有機會創造自己的未來.

最後廣告一下,公民除了有選舉權之外,也有罷免權,但是台灣罷免的條件反比選上難難難上許多,有興趣的人可以看看目前最大的O2O遊戲網站Appendectomy Project 割闌尾計畫,找回公民應有的權力.

這次選舉很不一樣,過去大家都說政治很黑暗,不要碰,自己也對這種鬧劇或只是權貴集團的遊戲沒什麼興趣,但這次身邊很多認識的人都投入了選戰之中,無論是幫忙的義工,或是本身就是參與者.第一次有哪麼多出身背景相似(就是沒什麼背景)的人,投入到政治之中,的確認政治離我們更近了一點,有機會看到那一點共同的未來.很高興大家的熱情與付出都有了結果,雖仍有不完滿,但也大大超出了我們自己原本的想像.

民主政治不需要神人,而是需要公民的共同參與,除了手上那張選票之外,平日的監督更是必要,只有親自參與政治,才有機會創造自己的未來.

最後廣告一下,公民除了有選舉權之外,也有罷免權,但是台灣罷免的條件反比選上難難難上許多,有興趣的人可以看看目前最大的O2O遊戲網站Appendectomy Project 割闌尾計畫,找回公民應有的權力.

2014年11月28日 星期五

Step by Step 使用github參與專案流程(下)- ISSUE,PR,and CI

當我們把修改後的檔案push上之後,就可以對原始的來源發PR(Pull Request).但是在發PR之前,先回過頭來說一下要從哪邊開始參與專案.參與專案通常可以分成幾種狀況,一種是自己發起,二是別人發起但是你是主要的參與者,三是周邊的參與者.如果你是前兩種狀況,那麼對於專案本身都會比較了解,知道要開發什麼功能,或是要改什麼東西.但是如果是周邊的參與者,通常不太可能一開始就跳下去做什麼重大的功能開發,而是從一些例如bug或是小功能著手.

2014年11月25日 星期二

2014年11月23日 星期日

Step by Step 使用github參與專案流程(上)- fork, clone, and sync

封面這隻章魚貓大家應該都不陌生,就是coding界的facebook--github的代表圖案.Github相關教學網路上已經很多了(最近最推薦這篇:連猴子都學得會的github),所以我就不再多介紹一些基本功能,而是從實戰角度來看如何透過github來參與線上專案.以下都拿我所參與的專案為例,這是一個源自於Google Cloud的開發專案,貢獻的規範相對嚴謹,可以學到很多管理或是參與專案的技巧.

2014年11月22日 星期六

[R] 當Text Mining專案完成度達到99%之後...

先前接下了一個號稱完成度99%的專案,只剩下一個小bug解決好就可以上線...故事由真人真事改編.故事背景是有個利用R來做text mining(文本分析)的專案要上線,這個專案使用了tm package和segmentCN兩個標準的配備(可以參考:[R] TEXT MINING(文字探勘、文本分析練習)).原本剩下這1%的問題在於開發環境和上線環境不同,導致結果的不一致.這個問題在當初我就有寫篇專文[R] tm package version 0.6 大解析(text mining文字探勘套件)來處理這個問題(使用了非常瑣碎的爛方法...有更好的方法請跟我說Orz).今天的故事是從這邊接下去開始...

2014年11月20日 星期四

[Apache Spark][基本架構] RDD特性(一)

萬丈高樓平地起,要熟悉Spark就得熟悉RDD,要熟悉RDD,就是要看Doc.延續著上一篇:[Spark][基本架構] 關於RDD中的不可變性(immutable),說到當我們對RDD做運算時,其實都會產生不同的RDD.RDD的官方文件(http://spark.apache.org/docs/latest/api/scala/index.html#org.apache.spark.rdd.RDD)一開始說到這些不同的RDD都共同擁有五個特性:

2014年11月18日 星期二

[Apache Spark][教學] 不要隨便Collect RDD!

先講結論:如果你的RDD很大,千萬不要隨便Collect.原文出處為http://databricks.gitbooks.io/databricks-spark-knowledge-base/content/best_practices/dont_call_collect_on_a_very_large_rdd.html.只說Collect會將所有元素複製到單一台機器上,但是沒說清楚為什麼會發生這種現象.

[Apache Spark][基本架構] 關於RDD中的不可變性(immutable)

剛開始接觸RDD時,會覺得RDD是一個裝資料的貨櫃(Container).再多瞭解一點後,才發現RDD更像裝洋片的太空包(

[Apache Spark][開發] 避免使用GroupByKey

雖然spark速度很快,但是沒有好好tuning還是沒辦法發揮它應該有的速度.避免使用GroupByKey牽涉到Spark底層處理資料時的方式.原始的文章和圖片皆來自Avoid GroupByKey,只有改成自己的範例.

[Scala][Spark] 型態抹除(it is eliminated by erasure)

之前python玩習慣了,在定義function的輸入變項時,不用特別去注意輸入變項是什麼型態,反正不管什麼型態的變項丟進來,python都會去執行程式,直到出現錯誤才會跳出.但是在scala這樣強型態的語言中,程式會在編譯階段就先定義輸入與輸出變項的型態,如果出現型態錯誤就無法繼續編譯.這樣的差異讓我在設計第一個總和的function就撞牆了.

2014年11月15日 星期六

[Scala][教學] Call by Name or Call By Value?

今天再看scala的教學課程看到的小觀念,記錄下來怕以後搞混。Scala再讀入參數的時候有兩種方式,預設是call by value,但是也可以改成call by name。兩者的差異在於:

Call by Value(default,透過x: Int的方式設定):呼叫函數的時候一併將值讀入。

Call by Name(透過x: => Int的方式設定):當函式碰到值的時候才去取值。

2014年11月13日 星期四

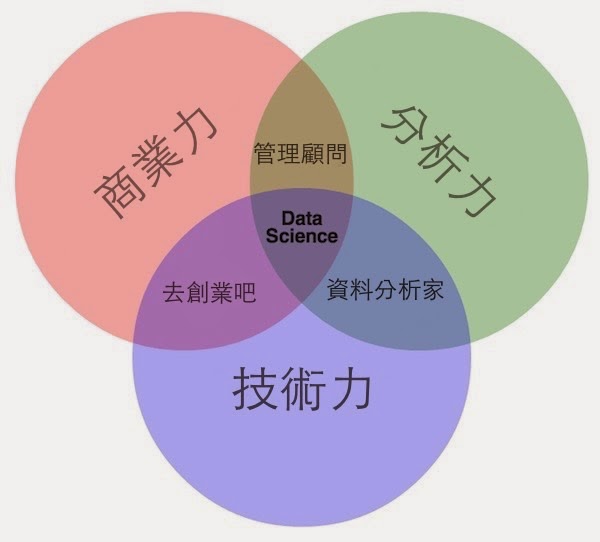

商業力 X 分析力 X 技術力 = 資料科學家三元素

資料科學家是近幾年出現的名詞(但是實際上已經存在於好幾百年),像是這篇“搶佔2013全球最性感行業”,以及曾經寫過的“資料科學家 vs 資料工程師“,甚至很誇張的”美企業搶資料科學家,兩年資歷年薪上看30萬美元“,讓很多人對資料科學家抱持的不同的幻想,在一般介紹資料科學的投影片中,最常出現的是下面這張圖:

2014年11月9日 星期日

[Apache Spark][教學] 應用IDEA以及Scala於Spark程式開發(圖多)

俗話說,工欲善其事,必先利其器,對於程式開發者來說,有個好的IDE介面絕對能大幅增加開發速度以及減少不必要的錯誤.先前在玩Spark的時候([Spark] 建立第一個RDD物件,體驗in Memory Computing的威力)是使用python,自然就是以Ipython notebook為首選,可以很方便的測試和操作RDD物件.但是因為Spark的原生語言其實是Scala,python在一些功能的支援上目前還趕不上Scala,所以目前選擇Scala作為開發Spark的主要工具.

2014年11月4日 星期二

[Algorithm] Stochastic gradient descent(梯度下降法)作為Online Learning Model(即時訓練模型)(二)

昨天最後我們停在Cost Function,再複習一下他的樣子:

θ為迴歸係數,要求得θ的最小值,也就是求上述Cost Function的最小值,統計上的做法就是直接將上述式子對每個係數做偏微分=0就可以計算出θ.這個方法完全沒錯,但是今天我要介紹的SGD是另外一種概念.

[Algorithm] Stochastic gradient descent(梯度下降法)作為Online Learning Model(即時訓練模型)(一)

因為數學不好,所以網誌成立以來一直沒有碰觸演算法相關的議題,但是隨著要分析的對象越來越複雜,可用變項指數成長,建模的時間也呈倍數縮短的情況下,還是要回到分析的根本--也就是數學模型來尋找突破的方法,所以開始認真的研讀演算法,這也是給予自己未來的目標,希望更深入的去了解常用的演算法.

2014年10月25日 星期六

[Python] K-means 分組 Script

K-means是一種非監督式學習的分類方式,原理將向量空間中的點分成k群後,計算每個點到群組中心的距離,目的在於使點到群心的距離成為最小(參考資料:http://en.wikipedia.org/wiki/K-means_clustering,https://www.youtube.com/watch?v=aiJ8II94qck).K-means因為容易理解,所以業界中也很常使用,本篇主要不是講解演算法,而是利用python中的sikit-learn套件製作一個小程式,讓使用者可以輕鬆的使用k-means演算法.

2014年10月23日 星期四

[職涯] 舒緩學習焦慮--沒有沒有用的學習歷程

我不知道有多少跟我一樣有學習焦慮,症狀就是覺得自己趕不上別人,有好多東西沒有學,但是學了之後又怕之後沒有用,常起處於焦慮狀態的人.這個禮拜一在Taiwan R User Group上聽到很多大大的學習歷程也是十分曲折,所以我也開始思考了自己過去的路徑.

2014年10月17日 星期五

[職涯] 在就職當天準備離職

圖片來源:http://intao.deviantart.com/art/Darkest-Path-193708896

標題下得很聳動,但是我不是在暗示想要離職(

見過一些朋友,工作了兩三年,覺得在現在的工作沒有發展性,調薪幅度有限,想要換工作時,發現自己除了現在的工作以外,其他什麼事情都不會做.這時候比較積極的一點會開始進修,培養新的專長;稍微平順一點的,就想不如再待一下,等有好機會再走.

結果這樣一待過了兩年,當拿著五年同工作的經歷去就業市場尋找機會時,沒想到自己年齡也大了,其他工作都寧可要更新鮮的肝;而這些職場五年級生也不干區就新鮮人的薪水,只好一邊留在原公司領那一年多不到3%的調薪,一邊抱怨薪水不如預期工作難找.

2014年10月12日 星期日

人生就是不停地戰鬥

“人生就是不停地戰鬥”這句話是九把刀的名言.我不是刀迷,但是很喜歡他這種用熱血包裝踏實的行動理念.我默約是從大學時代接觸到九把刀的小說,記得第一部吸引我的是“樓下的房客”,後來追了一系列的都市恐怖系列,也有follow它最早在kkcity上的個版.不過今天的重點不是要談小說.

記得他很早就有提到,寫小說沒什麼訣竅,就是固定一天寫三千字.我寫論文期間一天卯起來也才寫5000字而已,可見每天持續三千字的創作有多不容易(這還不包括了取材跟思考的時間).當時正值準備研究所的階段,說實在唸書也沒啥訣竅,每天固定八小時無論颳風下雨還是過年過節,就連分手隔天也是.

2014年10月11日 星期六

[R] 相見太晚,回頭是岸,分析WOE和IV值的神器套件

最近因為投入研究Spark,對於資料分析的東西比較沒時間琢磨,難得一個雙十假日又可以來體驗一下礦工的生活了.

Data mining不管是用何種方式建立模型,從幾百個變項中選出幾個候選變項往往是整個資料採掘過程最耗人的一個過程,實務上常使用WOE和IV用於變項篩選和分析(特別是信用評分卡模型),並透過WOE將原始資料離散化並取代後放入logistic模型中進行二分變項(結果只有0或1)的分析.

2014年10月10日 星期五

[Apache Spark][開發] 建立第一個RDD物件,體驗in Memory Computing的威力(二)

拖稿了一下,繼續來介紹SPARK的平行運算能力.前一篇[Spark] 建立第一個RDD物件,體驗平行運算的威力(一)我們透過python在SPARK上建立了第一個RDD物件,接著我們將開始對這個物件做一些操作.

2014年10月7日 星期二

[Apache Spark][開發] 建立第一個RDD物件,體驗in Memory Computing的威力(一)

RDD(Resilient Distributed Dataset)是SAPRK的核心概念和特色,最主要的特色在於:

1. RDD是基於在記憶體上的儲存和運算

2. RDD具備平行運算處理的能力

RDD背後有很深的理論和演算法基礎,想要有更深的了解可以參考這篇論文:Resilient Distributed Datasets: A Fault-Tolerant Abstraction forIn-Memory Cluster Computing

本文從實作方面來看一下如何透過python在spark上建立RDD物件,以及做基本的操作.

2014年10月4日 星期六

Like a Bat 從行銷中的分析單位到IT中的分析單位 - 後記

圖片來源:黑暗騎士劇照

前天發了篇Like a Bat 從行銷中的分析單位到IT中的分析單位,提到一些兩造的差異.但是過了一天又覺得差異其實並不若那麼大.

昨天和部門主管報告未來的專案規劃,被問到很多技術上的問題,諸如資料平台,可用的資料庫等等.在回答這些問題的過程中,我突然想起來過去在調查分析時的情況.過去在提案的時候,不也是會回答種種執行方法上的問題嗎?

2014年10月2日 星期四

Like a Bat 從行銷中的分析單位到IT中的分析單位

放Batman的圖片不是想說我變得很有錢。只是最近的心情讓我想到那個有關蝙蝠的預言故事。那個故事是這樣的:

很久以前,鳥類和走獸,因為發生一點爭執,就爆發了戰爭。并且,雙方僵持,各不相讓。

有一次,雙方交戰,鳥類戰胜了。蝙蝠突然出現在鳥類的堡壘。“各位,恭禧啊!能將那些粗暴的走獸打敗,真是英雄啊!我有翅膀又能飛,所以是鳥的伙伴!請大家多多指教!”

這時,鳥類非常需要新伙伴的加入,以增強實力。所以很歡迎蝙蝠的加入。

可使蝙蝠是個膽小鬼,等到戰爭開始,便秘不露面,躲在一旁觀戰。後來,當走獸戰勝鳥類時,走獸們高聲地唱著勝利的歌。蝙蝠卻又突然出現在走獸的營區。“各位恭禧!把鳥類打敗!實在太棒了!我是老鼠的同類,也是走獸!敬請大家多多指教!”

走獸們也很樂意的將蝙蝠納入自己的同伴羣中。

於是,每當走獸們剩利,蝙蝠就加入走獸。每當鳥類們打贏,卻又成為鳥類們的伙伴。

最後戰爭結束了,走獸和鳥類言歸和好,雙方都知道了蝙蝠的行為。當蝙蝠再度出現在鳥類的世界時,鳥類很不客氣的對他說:“你不是鳥類!”

被鳥類趕出來的蝙蝠只好來到走獸的世界,走獸們則說:“你不是走獸!”並趕走了蝙蝠。 最後,蝙蝠只能在黑夜,偷偷的飛著。

---- 資料來源:https://tw.knowledge.yahoo.com/question/question?qid=1007032307854

2014年9月30日 星期二

2014年9月29日 星期一

2014年9月21日 星期日

[Apache Spark][教學] Spark 單機版安裝教學(for mac)

最近SPARK在台灣相當火熱名媛最愛李宗瑞來這撿屍,潮男潮女富二代去的是(http://www.sparktaipei.com.tw),宅宅工程師只能在家玩Spark(https://spark.apache.org).

2014年9月20日 星期六

[R] tm package version 0.6 大解析(text mining文字探勘套件)

有在玩text mining的同好,最近不知道有沒有碰過類似的問題,就是很多以前用tm套件的程式跑不出來或有問題(先前文章[R] TEXT MINING(文字探勘、文本分析練習)就有使用這個套件)。這是因為tm套件在今年的6/1號升級到了0.6版(http://cran.r-project.org/web/packages/tm/index.html)改變了包裝corpus的方式(http://cran.r-project.org/web/packages/tm/news.html)很多東西都必須rebuild才能正常運作(其實這也是我個人的血淚經驗).

2014年9月13日 星期六

[R] 讀取大資料檔的效率比較:read.table vs freed

最近在玩Kaggle(https://www.kaggle.com/)上的資料,還沒開始分析就碰到了問題:檔案太大讀不進來.原始檔案約11G的CSV檔,我的電腦只有8g(ram),而R的特性偏偏又是要將檔案讀到記憶體中做運算,根本無法進入下一步.

2014年9月7日 星期日

[R] 到底還有什麼可以吃!!!???以社會網絡分析(Social Network Analysis)觀察地溝油事件

在進入本文前,先讓我們看部影片

所謂地溝油(http://zh.wikipedia.org/wiki/地沟油)就是廢物利用將使用過的油再次回收精煉使用的技術,技術層級超英趕美,是世界糧食的救星 ,本文的產生即是為了紀念這歷史性的一刻.

2014年9月5日 星期五

五個試著當顧問的理由-實踐篇

之前看了一篇Forbes的文章5 Reasons To Try Consulting (No Matter What You Want To Do)分享了從事顧問的五個主要理由.這些原因聽起來很吸引人,但是不是一加入顧問公司就能得到的.我想來根據過往經驗來補充一下如何才能感受到顧問業吸引人的地方.

2014年8月30日 星期六

[R] PTT推文文化的社群網絡分析(Social Network Analysis),帶你一窺社群網絡中的互動情況

資料科學愛好者年會開始囉!

今天是第一屆的資料科學愛好者年會http://twconf.data-sci.org票卷在九十分鐘內賣光,來不及報名的朋友可以來這裡看投影片和實況.

投影片在這裡:資料科學愛好者年會粉絲團 https://www.facebook.com/twdsconf?fref=ts

hackpad上的文字實況:https://hackpad.com/2014--yoCSWnghDWb

資料分析鍊金術(七)-insight?

圖片來源:http://www.cgma.org/Resources/Reports/Pages/insight-to-impact-big-data.aspx?TestCookiesEnabled=redirect

這幾年除了Big Data被超級濫用之外,Insight也是個聽到爛掉的名詞。人們已經無法滿足於單純的分析,而是想更進一步取得Insight,像是Custimer Research變成Customer Insight、或是乾脆用Insight代替Analysis的說法也有。那到底什麼是Insight?

這幾年除了Big Data被超級濫用之外,Insight也是個聽到爛掉的名詞。人們已經無法滿足於單純的分析,而是想更進一步取得Insight,像是Custimer Research變成Customer Insight、或是乾脆用Insight代替Analysis的說法也有。那到底什麼是Insight?

2014年8月25日 星期一

社會網絡分析(Social Network Analysis)--前言

我們都知道資料科學或是統計科學就是在找X變項與Y變項之間的關係,而一般我們在做資料分析或統計分析的時候,資料都會以下圖的方式呈現:

圖片來源:http://pages.bangor.ac.uk/~pes004/resmeth/msc/spss10.htm

,看不到之間的關係,在資料分析上產生了盲點。

2014年8月21日 星期四

[職涯] 累積你的人生,做出更多"對"的決定

今天早上看到這篇文章累積你的人生,做出更多「對」的決定很有感觸,跟大家分享一下心得。

"早知道當初就多陪她一點"、"早知道當初薪水談多一點"、"早知道當初應該堅持自己的看法"...等族繁不及備載。但是我們的生命很長,就算當下無法挽回,難道未來就沒有機會?

- 人生不是做錯一個決定就毀了

"早知道當初就多陪她一點"、"早知道當初薪水談多一點"、"早知道當初應該堅持自己的看法"...等族繁不及備載。但是我們的生命很長,就算當下無法挽回,難道未來就沒有機會?

2014年8月18日 星期一

[R][翻譯] 快速計算統計資訊(使用dplyr 套件)

dplyr是個實用好用的套件,主要功能是用來取代運算慢的SQL套件,來做變項的aggregate運算。(不過在我還是新手的時候SQL套件真的幫了我很多忙XD) 這篇文章的原文為:

Using R: quickly calculating summary statistics (with dplyr)

2014年8月13日 星期三

工作與生活的平衡(?)--小琉球海龜超近距離接觸!

前陣子我離職了XD,在接續下一段工作之間,給自己放一段小假,去了一直很想去的小琉球潛水,看了很爽的演唱會(山海屯音樂節) ,陪了疏忽很久的女朋友。這段期間完全放空自己,不但沒工作,書也沒看、教學影片什麼的也沒有看,網誌沒寫,也沒碰任何程式,將自己從過去平常的生活模式完全抽離出來。

2014年7月30日 星期三

[R] SQLDF VS LAPPY效率測試

剛開始學R的時候對於R的指令很不熟,所以大部分都習慣用sqldf來寫查詢指令。隨著對R的熟悉,最近也在嘗試用R內建的fnction來查詢資料,所以才想說來比較一下兩者的效能差異。俗話說時間就是金錢,在處理大量數據的時候,對於處理速度更是要斤斤計較。

訂閱:

意見 (Atom)